La conscience de soi nous apparaît

comme une donnée essentielle de notre humanité, comme le fait d’avoir

des bras et des jambes. Et si c’était un phénomène culturel, changeant ?

Et si la conception du « soi » avait fluctué selon les époques ?

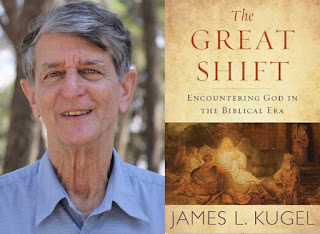

Dans un article paru en 2017 pour The Atlantic, la journaliste Sigal Samuel a interrogé le spécialiste de la bible James Kugel, qui dans son livre The Great Shift

s’interroge sur la notion que les anciens Hébreux avaient des limites

de leur individualité – et comment cela pourrait expliquer un phénomène

comme le prophétisme.

Pour Kugel en effet, le moi des personnages de la Bible était « semi-perméable » autrement dit, il était en mesure d’être « envahi » par des entités extérieures (Dieu, dans le cas des prophètes, mais il y avait aussi des anges et des démons), et ils pouvaient alors « entendre des voix » leur disant quels actes accomplir. « Ainsi, quand la Bible dit que Dieu est apparu à Abraham en dehors de sa tente ou a parlé à Moïse depuis un buisson ardent, nous sommes portés à rejeter ces choses comme une sorte de langage figuratif, ou bien nous les ignorons. De telles choses se sont produites dans le passé, mais ne le font plus aujourd’hui. »

Les anciens avaient-ils deux esprits ?

Comme le souligne Deric Bownds dans son court post de blog sur cette interview, à aucun moment ni le journaliste ni Kugel ne mentionnent les théories de Julian Jaynes. Ce qui est étonnant, car Julian Jaynes, depuis la sortie de son livre en 1976, The Origin of Consciousness in the Breakdown of the Bicameral Mind (traduit en 1994 en français sous le titre La naissance de la conscience dans l’effondrement de l’esprit, la suppression du mot « bicaméral » rendant le titre incompréhensible), est considéré comme le géniteur de cette théorie du caractère historique de la conscience de soi.

Jaynes, lui n’a pas commencé ses recherches sur la Bible, mais sur le texte d’Homère, l’Iliade. Dans cette épopée il n’est pas rare non seulement pour les dieux d’apparaître aux différents protagonistes de l’histoire, mais aussi et surtout, d’inspirer les héros, de les pousser à commettre des actes dont certains auront d’ailleurs des conséquences catastrophiques. Pour employer le néologisme de Kugel, leur individualité était « semi-perméable ».

L’origine de cette caractéristique psychologique était, selon Jaynes,

le caractère « bicaméral » de notre cerveau. Ce n’est plus un secret

pour grand monde que notre cortex est divisé en deux hémisphères, le

droit et le gauche. Mais, observe Jaynes dans son livre, alors qu’un bon

nombre de fonctions mentales sont bilatéralisées, les aires du langage

(celles de Wernicke et de Broca) se trouvent toutes les deux dans la

partie gauche. Et ce, bien que rien n’empêcherait théoriquement d’avoir

leur équivalent dans la partie droite. Il observe en effet qu’un enfant

ayant une lésion de l’aire de Wernicke développera un remplacement dans

l’hémisphère droit de son cerveau. Pourquoi donc, se demande-t-il, le

langage ne s’est-il développé que dans la partie gauche ? A quoi servent

les zones de l’hémisphère droit qui normalement auraient dû servir à la

maîtrise du langage ?

Pour Jaynes : « Les pressions sélectives de l’évolution qui auraient

pu produire un si puissant résultat sont celles exercées par les

civilisations bicamérales. Le langage des hommes n’a été développé que

dans un seul hémisphère pour laisser l’autre libre pour le langage des

dieux. »

Le héros homérique n’a donc aucune volonté propre, aucune conscience de soi. Selon Jaynes, à part quelques passages interpolés tardivement, L’Iliade ne possède pas de référence à des concepts qui traduisent l’unité de l’être humain. Par exemple, le mot grec « psyche » qui par la suite en viendra à désigner l’âme, n’est employé que pour décrire des substances vitales comme le souffle ou le sang. Par exemple un guerrier agonisant est en train de perdre sa psyche qui se répand sur le sol. Mais, et c’est encore plus surprenant, pas de référence non plus au corps comme une unité unique et autonome. Le mot « soma » (corps) est employé exclusivement pour parler des cadavres. Homère ne mentionne que des parties du corps, les mains, les bras les jambes, etc., mais jamais le corps dans son ensemble.

Pour Jaynes les héros grecs étaient exempts de vie intérieure et étaient menés par les commandements des dieux, ces hallucinations auditives en provenance de leur cerveau droit. « C’étaient de nobles automates qui ne savaient pas ce qu’ils faisaient. »

Mais comment est-on passé de ce monde sans conscience de soi à l’esprit humain tel que nous le connaissons aujourd’hui ? Selon Jaynes, c’est parce qu’il s’est produit un « effondrement » de l’esprit bicaméral qui a marqué la naissance de l’individualité telle que nous la connaissons. Tant que les humains vivaient dans de petites communautés agricoles (Jaynes ne s’occupe pas des sociétés de chasseurs-cueilleurs), ce système fonctionnait à merveille. Chacun possédait un « leader intérieur », un Dieu ou un ancêtre puissant, qui lui disait à chaque instant comment agir. Mais lorsque les communautés se sont agrandies, que les premières cités et empires sont apparus, les prises de décisions sont devenues de plus en plus complexes et il a fallu développer une nouvelle forme de pensée, dans laquelle chaque individu était tenu de prendre des responsabilités personnelles. L’Odyssée, également attribuée à Homère, mais plus tardive que l’Iliade, nous montre des personnages dotés d’une conscience de soi déjà « moderne ».

Une théorie contestée, mais « pop »

Quel a été l’impact de la théorie de Jaynes ? Comme le dit Vaughan Bell sur Mind Hacks : « sa théorie de la conscience est très probablement fausse, mais si terriblement originale qu’elle est largement admirée ». De fait, quelqu’un comme le biologiste Richard Dawkins a dit du livre de Jaynes qu’il était « soit du grand n’importe quoi, soit une œuvre de pur génie ». Le philosophe Daniel Dennett s’est aussi intéressé aux thèses de Jaynes et a même écrit un article assez long sur le sujet (.pdf).

Il est intéressant de voir que deux des grands hérauts du « nouvel

athéisme » et de l’hyperrationalisme ont une attitude prudente et plutôt

sympathique envers les thèses de Jaynes, qui pourraient paraître

joyeusement délirantes.

Quel a été l’impact de la théorie de Jaynes ? Comme le dit Vaughan Bell sur Mind Hacks : « sa théorie de la conscience est très probablement fausse, mais si terriblement originale qu’elle est largement admirée ». De fait, quelqu’un comme le biologiste Richard Dawkins a dit du livre de Jaynes qu’il était « soit du grand n’importe quoi, soit une œuvre de pur génie ». Le philosophe Daniel Dennett s’est aussi intéressé aux thèses de Jaynes et a même écrit un article assez long sur le sujet (.pdf).

Il est intéressant de voir que deux des grands hérauts du « nouvel

athéisme » et de l’hyperrationalisme ont une attitude prudente et plutôt

sympathique envers les thèses de Jaynes, qui pourraient paraître

joyeusement délirantes.

De fait, la thèse de Jaynes n’a jamais été véritablement réfutée, elle a tout simplement été ignorée, note Marcel Kuijsten le directeur de la Julian Jaynes Society, dans une interview pour Inverse.

En fait l’impression générale est que la thèse de Jaynes séduit beaucoup de monde, mais qu’elle est trop excentrique, trop extrême pour être réellement soutenue.

En tout cas, si cette thèse reste assez marginale dans la psychologie aujourd’hui, elle a fait son chemin dans la pop culture.

Dans le comics Uncanny x-men, écrit par Chris Claremont au début des années 80, l’un des mutants, la Bête, se réjouit de lire le livre de Jaynes et se demande quand sortira le film. De fait, il y a bien aujourd’hui un film, ou plus exactement une série, puisque la théorie de l’esprit bicaméral se trouve au coeur de la fameuse série de HBO, Westworld.

Westworld nous présente l’histoire d’un parc d’attractions futuriste construit à l’image du Far West, peuplés par des robots jouant de manière indéfiniment répétée leur rôle dans des scénarios interactifs de western à destination des visiteurs. Puis, comme toujours avec les robots, tout se détraque. Mais Westworld est plus fin et plus subtil que la plupart des « révoltes de robots » auxquelles la science-fiction nous a habitués (et certainement plus sophistiqué que le film de 1973 dont la série est tirée). C’est l’accession à la conscience qui est au coeur des épisodes.

La théorie de l’esprit bicaméral est mentionnée de façon explicite à plusieurs reprises lors de la première saison (« the bicameral mind » est même le titre de l’épisode final).

L’intrigue de Westworld repose sur une idée particulièrement importante de Jaynes. Ce serait le développement de notre langage et notre capacité à la métaphore qui aurait généré un « espace intérieur » propice au développement de la conscience de soi. Le langage serait donc un prérequis à l’acquisition de la conscience.

Selon le journaliste d’Inverse, Andrew Burmon : « En présentant le concept, les auteurs de Westworld montrent clairement que les robots dotés d’IA de la série ne sortent pas de la servitude préprogrammée à cause d’un pépin ou d’un virus – comme c’était le cas dans le film original. Ils se détraquent à cause de leur exposition à un langage de plus en plus complexe. »

Marcel Kuijsten, dans son interview avec Burmon, précise que « lorsque nous parlons de l’esprit bicaméral, nous parlons de cette période suivant le développement du langage, mais avant que nous apprenions la conscience. Au lieu d’un esprit-espace introspectif, nous entendions une voix dominante lorsque nous avions des décisions à prendre. À mesure que le langage s’est complexifié à travers la métaphore, nous avons développé la capacité d’introspection et, petit à petit, les hallucinations ont disparu. »

Une longue vidéo (en anglais, mais avec des sous-titres) dégottée par Io9, nous donne encore quelques clés supplémentaires pour comprendre la façon dont Westworld s’inspire des thèses de Jaynes.

Pour l’auteur de ce petit film (attention spoilers !), en dehors du langage et de la métaphore, c’est une autre caractéristique de la conscience qui est mise en lumière par la série : la possibilité de créer des narrations avec nous-mêmes au centre. La conscience serait donc peut-être aussi la capacité de nous raconter nos propres histoires.

Entendre des voix, c’est normal, docteur ?

La thèse de Jaynes est elle convaincante ? A mon humble avis, pas toujours. Ce genre d’hypothèse repose souvent sur des présupposés interprétatifs qui sont difficiles à réfuter ou valider de façon certaine. Autrement dit, le biais de confirmation fonctionne à plein : si vous croyez aux idées de Jaynes, vous verrez le cerveau bicaméral partout. Si vous êtes sceptiques, rien ne pourra véritablement vous convaincre.

Ce qui est sûr, c’est que les civilisations non occidentales ont pour la plupart abrité dans leur sein des « spécialistes » qui recevaient des messages des « dieux » ou des esprits : shamans dans les groupes de chasseurs cueilleurs, « possédés » ou « oracles » dans les sociétés agricoles. Et il est certain que la parole de ces personnes était considérée avec le plus grand sérieux, et que ce comportement était donc encouragé, alors que dans notre civilisation, il serait rejeté comme hallucinatoire et pathologique. Faut il pour autant en déduire que TOUTE la population était sujette à de genre d’hallucination ?

Dans son interview avec Andrew Burmon, Marcel Kuijsten explique que beaucoup de gens critiquent l’idée de l’esprit bicaméral parce qu’elle implique une évolution bien trop rapide du cerveau, quelque chose que la théorie darwinienne ne peut justifier. Mais précise-t-il, « Jaynes n’affirme jamais qu’il s’agit d’un changement biologique et évolutif. Il parle d’un processus appris. Daniel Dennett, le professeur de philosophie, utilise une métaphore : c’est un changement de logiciel, pas un changement de matériel. C’est comme un nouveau système d’exploitation. »

Sans doute, mais un changement au sein de la société et de nouvelles normes sur les comportements provoqueraient sans doute une transition encore plus rapide que le changement d’un « système d’exploitation psychologique » touchant tous les individus.

Cela semble être la différence entre le récent travail de Kugel et la théorie de Jaynes. Si l’on suit son interview de The Atlantic, selon Kugel, le fait « d’entendre des voix » est toujours d’actualité dans de nombreux pays :

« Il cite… une récente étude interculturelle lors de laquelle des chercheurs ont interviewé des auditeurs aux États-Unis, au Ghana et en Inde. Les chercheurs ont enregistré des «différences frappantes» dans la façon dont les différents groupes de personnes ressentaient les voix qu’ils entendaient : Au Ghana et en Inde, de nombreux participants ont insisté sur le fait que leur expérience prédominante ou même unique était positive. … Cela n’a été le cas pour aucun américain. »

« Ces résultats », conclut Kugel, « suggèrent que les » données « d’une société ont beaucoup à voir avec la manière dont l’audition vocale est interprétée. »

Toujours selon Kugel, il existe aujourd’hui 15 % de personnes qui ont entendu des voix au moins une fois dans leur existence (aux Etats-Unis, ils ont même une association). Reporté à l’antiquité biblique, et sans aller chercher un nouveau type de conscience, cela aurait fait 15 % de prophètes, ce qui aurait été largement suffisant (et peut-être même un peu trop).

Évidemment, si la conscience de soi, n’est ni un phénomène biologique, ni même psychologique, mais repose avant tout sur un système de normes, cela veut dire que l’esprit bicaméral ne s’est jamais « effondré ». Et il peut toujours redevenir d’actualité en cas de changement ou de crise de notre logiciel social.